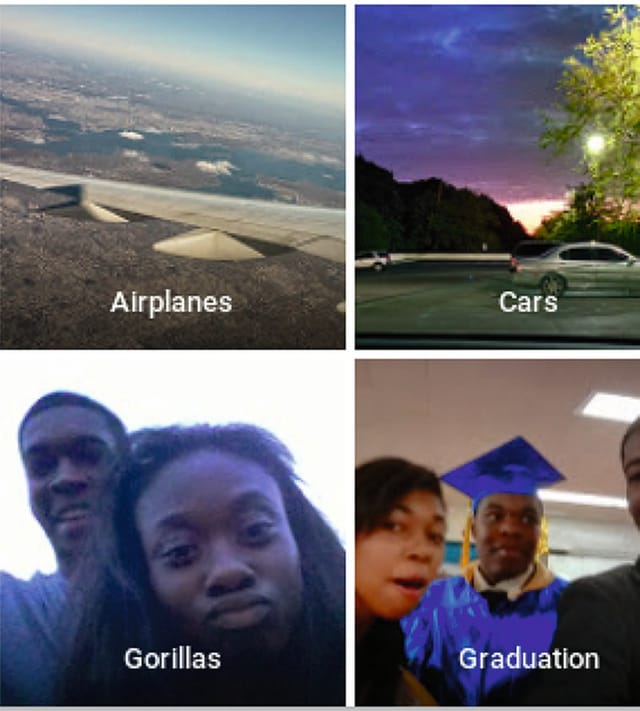

Gorillákként azonosította minap a fekete bőrű programozót és barátnőjét a Google fotós szolgáltatása, amely a feltöltött képeket automatikusan címkézi, jelezve, hogy mi látható rajtuk. Az eset nem egyedi: májusban a Flickr ingyenes fényképmegosztó oldal sült fel hasonló, a rendszerezést, keresést megkönnyítő funkciójával. „Fejlett képfelismerő technológiája” nem csupán egy fekete férfit „majmozott le”, hanem például az egykori dachaui koncentrációs tábor kapuját mászókának nézte. A bocsánatkérés mellett mindkét cég arra bátorította a felhasználókat, hogy nyugodtan javítsák ki maguk a hasonló tévedéseket (vagyis töröljék a téves címkéket a képekről), mert a programok így tanulnak.

Való igaz, hogy az említett képfelismerő szolgáltatások olyan neurális hálózatokra (angol szakkifejezéssel: convolutional neural networks) épülnek, amelyek az agy tevékenységét utánozzák. A működési elvüket már az 1980-as években felvázolták, ám a hétköznapi gyakorlatba csak az utóbbi pár év számítástechnikai fejlődése nyomán kerülhettek be. Lényegük a folyamatos tanulás. Hatalmas adatbázisokból rengeteg változatban mutatják meg nekik a kijelölt címkéknek megfelelő – például kutyákat, madarakat, tájképeket, embereket, épületeket vagy autókat ábrázoló – fotókat, így egyre nagyobb eséllyel ismerik fel a hasonló témájú képeket, és minden egyes további sikeres (vagy sikertelen) próbálkozásból tanulnak.

A felhasználói visszajelzések szerint még manapság is előfordul ugyan, hogy az efféle programok egy-egy nagyobbacska kutyát esetleg lónak látnak, de az emberek többségéhez képest máris jobban megbirkóznak az olyan feladatokkal, mint a finom osztályozások, így a madár- vagy növényfajták felismerése. Ezzel szemben mind a mai napig könnyen becsaphatók a nagyon kicsi képelemekkel vagy a finom vonalú részletekkel (hangya egy virágszáron, madártoll valakinek a kezében). Ugyancsak nehezen boldogulnak a számítógépek az internetes képmegosztó oldalakon rendkívül népszerű, szűrőkkel eltorzított (például régiesített) képekkel. De az is megizzaszthatja a mesterséges intelligenciát, ha a szembetűnő, nagyméretű, gyakran látható alaptárgyak, alakok (emberek, repülők, autók, épületek, növények, állatok) apró részletként, a környezetbe olvadva, netán szokatlan, „dizájnolt” formában jelennek meg. Gyerekcipőben jár továbbá a képeken látható jelenetek elemzése, vagyis annak megállapítása, hogy mi történik valójában: simogatnak egy kutyát, vagy az éppen megtámadja az embert.

Ahhoz, hogy meg lehessen tanítani ezeket a nagy rendszereket a képek felismerésére, a szó szoros értelmében ízeire kell szedetni velük azokat. A digitális fotókat a Google és a Flickr alkalmazása is egészen apró részletekre bontja, majd átfuttatja őket a mesterséges idegsejtként működő úgynevezett rétegek sorozatán. Ezek egyre magasabb szintű szervezettségeket képesek felismerni. Az első rétegcsoport például a legalapvetőbb képalkotókat tudja azonosítani (egyenes vonalak, kontúrok, sarkok, kis körívek), a második már ezek bonyolultabb kombinációival is elboldogul (körökkel, alapvető formákkal). A további szintek aztán ezen információk alapján még összetettebb alakzatokat értelmeznek, előbb például a szemeket, az ajtókat, a leveleket vagy egy csőrt, majd a szárnyakat, a fejeket és így tovább. A legvégén az algoritmus összesíti az adatokat és nagy biztonsággal megtippeli, mit ábrázol a kép.

Gond azonban, hogy ezek a neurális hálózatok annyira bonyolultak és annyira önállóan fejlődnek, hogy a kutatók és fejlesztők beismerték: nem igazán tudják, mi történik a rétegek mélyén. Amikor ezt felderítendő a Google mérnökei nemrégiben megpróbálták „visszafelé” dolgoztatni az algoritmusokat, vagyis előzőleg betanított tárgyakat, élőlényeket rajzoltattak velük, meglehetősen szürreális eredmények születtek: a számítógép láthatóan inkább egyes részleteket ismert fel, semmint a nagy egészt. Ugyanekkor az is kiderült, hogy a mesterséges intelligencia a nem teljesen egyértelmű fotókon hajlamos olyasmiket azonosítani, amikre sokat tanították: ha például többnyire állatokat mutogattak neki, akkor mindenben (felhőkben, fákban, levelekben) állatokat fog látni. Elképzelhető, hogy ilyesmi állhat a minapi kínos gorillás malőr hátterében is.

Még meglepőbb, hogy az algoritmusok a véletlenszerűen létrehozott, absztrakt képekbe is bele „akarnak” látni valamit – publikálta májusban a Wyomingi Egyetem mesterséges intelligenciával foglalkozó kutatója, Jeff Clune és csapata. Vízszintesen váltakozó sárga és fekete csíkokat például iskolabusznak látnak, a tévés adásszünetre emlékeztető összevissza ponthalmazokat pedig 99 százalékos valószínűséggel azonosítják – hol százlábúként, hol buborékként, hol gepárdként vagy pávaként. Clune-ék szerint ez azért fordulhat elő, mert a számítógépek – az emberi szemmel ellentétben – hozzászoktak a fotók képpontokra bontásához, és ebből azt tanulták meg, hogy például „a zöld pixel, zöld pixel, lila pixel, zöld pixel sorozat” gyakran fordul elő pávákat ábrázoló képeken.

A gond csak az, hogy ha valóban a pixelek sorrendjén és mintázatán múlik egy-egy kép „jelentése”, akkor nem is olyan nehéz becsapni ezeket az algoritmusokat. Ennek ismeretében például pornográf fotókat lehet átjuttatni internetes szűrőkön, de a már viszonylag megbízhatóan működő arcfelismerő szoftverek is lóvá tehetők. Ezért a programozókat arra kellene sarkallni – hívja fel a figyelmet Clune –, hogy az általuk fejlesztett algoritmusok ne vesszenek el a részletekben, hanem egyre inkább figyeljék egy-egy kép globális szerkezetét, ahogyan azt az emberi szem is teszi

ILLÉNYI BALÁZS