Áradt a felgyorsult Tisza és mindent letarolt

A magyarországi kihalt falvakról szóló sorozat egyik legkülönlegesebb túrája, amolyan Tüskevár-érzés volt, amikor Tiszahalász emlékei után kutattunk.

A laboratóriumi benchmark-mérőszámok gyakran túlzottan optimista képet festenek a mesterséges intelligenciák képességeiről – mutat rá egy friss kutatás, mely a hazai kompetenciamérés kérdéseivel tesztelt hat népszerű modellt.

Átfogó kutatást végeztek a jelenleg legismertebb mesterségesintelligencia-modellek teljesítményéről. A PeakX fókuszában az volt, hogy valós környezetben milyen eredményeket érnek el az egyes modellek szövegértési, matematikai és egyéb tudományterületeken.

A kutatás során a nagy nyelvi modelleknek a magyarországi kompetenciamérések során a 6., 8. és 10. osztályos diákok által kitöltendő teszteket kellett megoldaniuk. A PeakX 70 szövegértési és 70 matematikai feladatot használt az MI-modellek tesztelésére, kiegészítve történelem, természettudomány és digitális kultúra kérdésekkel. Az eszközök által adott válaszokat objektív pontozási rendszerrel értékelték, valamint több szempontot is figyelembe vettek – így a gyorsaságot, erőforrásigényt és pontosságot is.

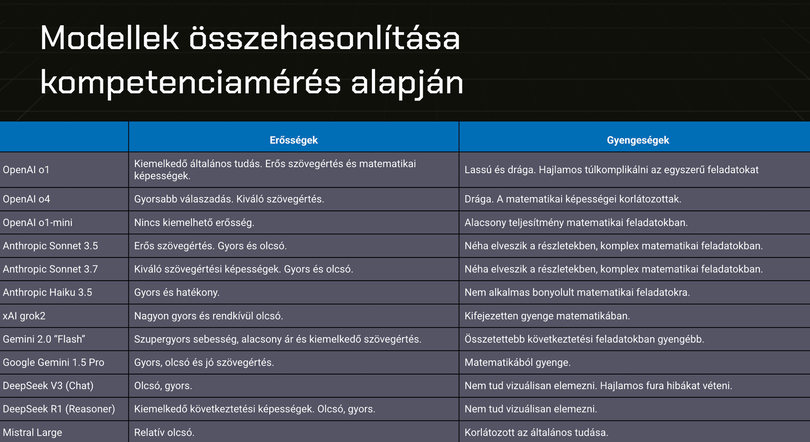

Az elemzés során megállapították, hogy a vizsgált modellek között jelentős eltérések tapasztalhatók a szövegértési és matematikai feladatok terén. Az egyes eszközök – konkrét nyelvi modellek – erősségeit és gyengeségeit ki is emelték:

Mint összegeznek, az érvelő (reasoning) modellek lassabbak és drágábbak, de minden kategóriában jobb eredményt értek el, mint a többi modell. Az eredmények alapján a nagy nyelvi modellek a problémamegoldó és analitikus készségeket igénylő területeken még nem képesek egyértelműen helyettesíteni az embereket, különösen a komplex matematikai készségeket igénylő feladatoknál mutatkozik meg lemaradásuk.

Azt ugyanakkor érdemes számításba venni, hogy MI-téren rendkívül erős a verseny, és szinte naponta jelennek meg új nyelvi modellek – így a fenti vizsgálat csak egy pillanatnyi állapotot tükröz.

Ha máskor is tudni szeretne hasonló dolgokról, lájkolja a HVG Tech rovatának Facebook-oldalát.

A magyarországi kihalt falvakról szóló sorozat egyik legkülönlegesebb túrája, amolyan Tüskevár-érzés volt, amikor Tiszahalász emlékei után kutattunk.

Pannonhalmán mondta el augusztus 20-i ünnepi beszédét a Tisza Párt elnöke.