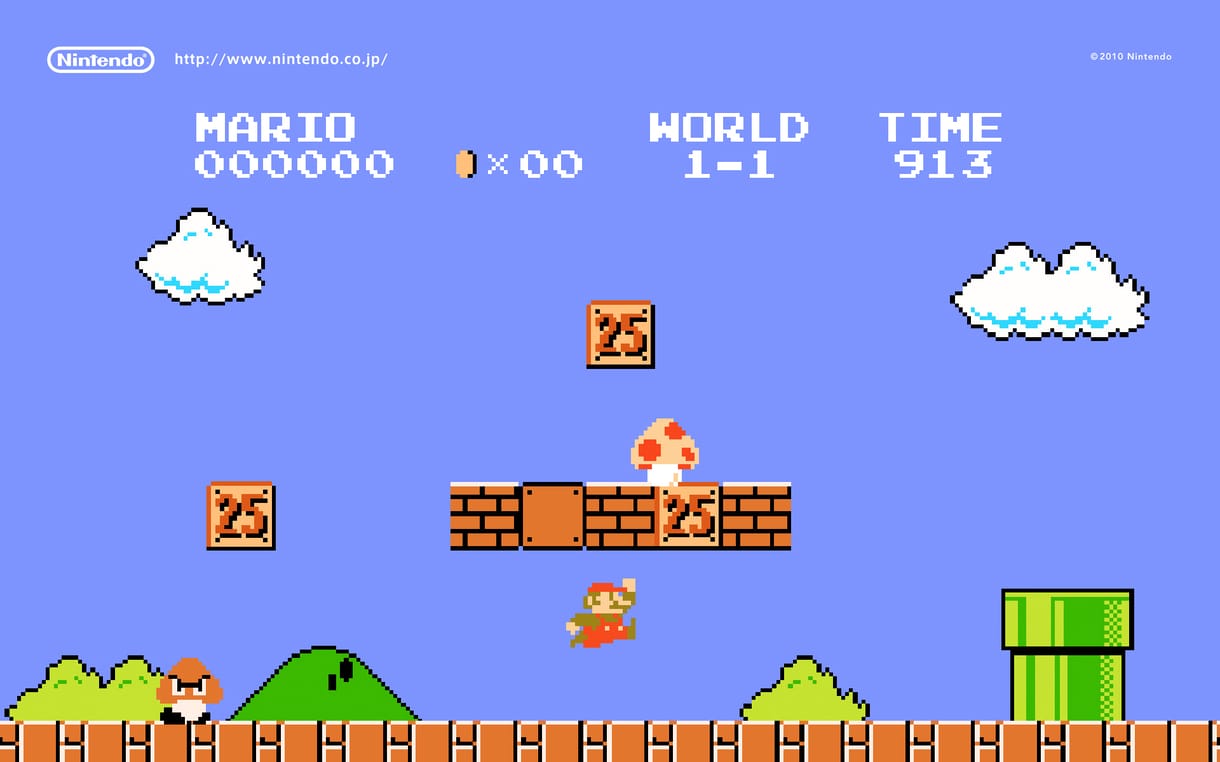

Benchmark programokról hallva komoly, elvont szoftverekre gondolunk, és az esetek többségében ez így is van. A mesterséges intelligencia kutatói viszont olykor játékokkal vizsgáztatják fejlesztéseiket, korábban például a Pokémonra szabadították rá a MI-t. Nehezebb feladatot keresve, ezúttal a klasszikus Super Mario Bros. játékot választották „benchmarknak” a Kaliforniai Egyetem MI-laboratóriumának (Hao AI Lab) kutatói, hogy teszteljék a mesterséges intelligenciákat.

A játék persze nem egészen ugyanaz volt, mint az 1985-ös klasszikus. Egy emulátorban futott, és integrálták a GamingAgenttel, egy házon belül kifejlesztett keretrendszerrel, amely lehetővé teszi az MI-k számára, hogy irányítsák Mariót, és elkerüljék például az akadályokat és az ellenségeket. Az AI ezután bemeneteket generált a Mario vezérléséhez Python kód formájában. A kutatók szerint ez az egyedülálló játékkörnyezet arra kényszerítette az egyes modelleket, hogy bonyolult manővereket és játékstratégiákat dolgozzanak ki, ennek alapján lehetett tesztelni az alkalmazkodóképességüket és a problémamegoldó készségeiket.

A mesterséges intelligenciák nem teljesítettek egyformán. Érdekes módon az olyan gondolkodási modellek, mint az OpenAI GPT-4o, gyengébben szerepeltek, annak ellenére, hogy a legtöbb benchmarkon összességében jobb teljesítményt nyújtottak. Ennek az oka a lassabb döntéshozatali folyamatuk volt, gyakran másodpercekig agyaltak, mielőtt cselekedtek volna. A nem okoskodó modellek ezzel szemben felülmúlták őket, ami érthető, hiszen ebben a játékban minden az időzítésen múlik. Egyetlen másodperc jelentheti a különbséget a biztonságos ugrás és a halálba zuhanás között. Összességében az Anthropic Claude 3.7-e teljesített a legjobban, majd a Claude 3.5 következett. A Google Gemini 1.5 Prónak és az OpenAI GPT-4o modellnek viszont (az említett) problémái voltak.

Az, hogy játékokkal teszteljék a mesterséges intelligenciát, nem új ötlet, viszont a hasznosságát illetően nincs egyetértés a kutatók között. Vannak ugyanis szakértők, akik szerint nem a „játéktudás” mutatja egy MI rátermettségét, különös tekintettel arra, hogy a való világtól eltérően a játékok általában absztraktak és viszonylag egyszerűek, ráadásul elméletileg végtelen mennyiségű adatot biztosítanak az MI betanításához.

Ha máskor is tudni szeretne hasonló dolgokról, lájkolja a HVG Tech rovatának Facebook-oldalát.