Már a Meta is látja, mennyire veszélyesen rosszul tudják használni a felhasználók a mesterséges intelligenciáját, a Meta AI-t. Nem arról van szó, hogy rossz parancsokat írnának be a rendszerbe – ilyen lényegében nem létezik, hacsak nem a törvényességi keretek menténk határozzuk ezt meg –, sokkal inkább arról, hogy túlságosan személyes tartalmakat tesznek közzé.

A Business Insider korábban arról írt, hogy a MetaAI alkalmazásban a felhasználók – valószínűleg akaratukon kívül – intim, kínos, és időnként a személy beazonosítására alkalmas – az MI-vel folytatott – beszélgetéseket tettek közzé az alkalmazás dedikált hírfolyamában. (Ez Magyarországon jelenleg nem érhető el.)

Bár a Meta AI alapértelmezés szerint nem osztja meg a felhasználók csevegési előzményeit, úgy tűnik, hogy az alkalmazás számos felhasználója úgy döntött, hogy ezt megteszi anélkül, hogy tudatában lett volna annak, hogy ezzel a hang- és szöveges csevegések nyilvánosan is láthatóvá válnak. Az Engadget beszámolója szerint volt, aki a bélmozgással kapcsolatos kérdéseket tett fel a rendszernek, mások pedig az adózással kapcsolatos kiskapukról érdeklődtek. A lap szerint volt olyan is, aki a csevegéshez odaírta, hogy a Meta AI tartsa titokban a beszélgetést.

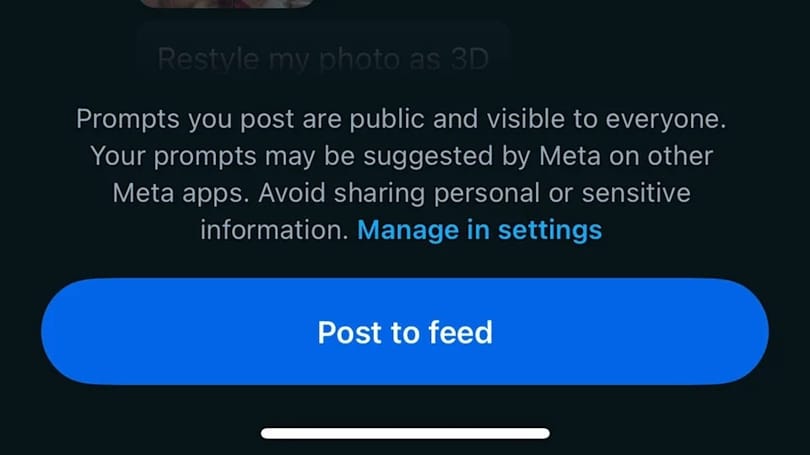

De visszatérve a Metára: a cég úgy döntött, hogy egy figyelmeztetést ad ahhoz a gombhoz, amivel a felhasználók megoszthatják a nyilvánossággal a beszélgetéseiket. Ebben a cég világossá teszi, hogy a parancsok és lekérdezések mások számára is elérhetővé és láthatóvá válhatnak, így lehetőség szerint senki se osszon meg a rendszerrel érzékeny információkat.

A Business Insider szerint a Meta nemcsak ezt lépte meg, így a nyilvános hírfolyamban már nem érhetők el, csak a mesterséges intelligencia által generált képek és videók.

Az adatvédelmi szakemberek mindenesetre kritizálták a Metát, mondván, hogy egyetlen más hasonló szolgáltatás sem teszi lehetővé, hogy a chatbottal folytatott üzenetváltások nyilvánossá váljanak.

Ha máskor is tudni szeretne hasonló dolgokról, lájkolja a HVG Tech rovatának Facebook-oldalát.